O Fim da Era do Gelo: O Futuro do Computador Quântico

Imagine por um instante um laboratório farmacêutico onde o desenvolvimento de um novo medicamento para o Alzheimer não leva uma década, mas meras semanas. Pense em cientistas de materiais projetando, átomo por átomo, um novo tipo de catalisador capaz de extrair CO₂ da atmosfera com uma eficiência que hoje parece mágica. Visualize um sistema de inteligência artificial resolvendo problemas de logística global tão complexos que economizariam bilhões de dólares e reduziriam drasticamente nossa pegada de carbono. Essa visão, que habita o território da ficção científica para muitos, é a promessa fundamental do computador quântico. Contudo, por décadas, essa promessa esteve acorrentada por um desafio de engenharia colossal, uma barreira que parecia tão intransponível quanto as próprias leis da física.

Para construir essa máquina revolucionária, precisávamos domar o mundo subatômico, um reino de fragilidade extrema. Agora, após mais de dez anos de pesquisa obstinada, uma equipe de cientistas anunciou uma descoberta que finalmente quebrou uma dessas correntes, resolvendo o maior gargalo prático no caminho para a computação quântica em larga escala.

O Paradoxo Quântico: Poder Imenso, Fragilidade Extrema

Para compreender a dimensão desse avanço, é preciso antes mergulhar na natureza bizarra e contraintuitiva do mundo quântico. Um computador clássico, como o que está em seu smartphone ou laptop, funciona com base em bits, interruptores minúsculos que podem estar em um de dois estados: ligado (1) ou desligado (0). É um sistema binário, previsível e robusto.

O computador quântico, por outro lado, opera com uma unidade fundamental muito mais poderosa e estranha: o bit quântico, ou simplesmente “qubit”. É a propriedade única dos qubits que confere a essas máquinas um potencial de cálculo que supera exponencialmente até mesmo os supercomputadores mais potentes do planeta. Mas, como em um grande drama, esse poder extraordinário vem acompanhado de uma vulnerabilidade igualmente extraordinária, um verdadeiro calcanhar de Aquiles que tem sido o foco de pesquisadores em todo o mundo.

O que são Qubits? Uma Breve Imersão

Diferente de um bit, um qubit não precisa escolher entre 0 e 1. Graças a um princípio chamado superposição, ele pode ser 0, 1, ou uma combinação de ambos os estados simultaneamente. Pense em um bit clássico como uma moeda deitada sobre uma mesa, mostrando cara (1) ou coroa (0). Um qubit, em contrapartida, é como essa mesma moeda girando no ar, existindo em uma névoa de probabilidades de ser cara e coroa ao mesmo tempo. Somente quando a medimos, forçamos a moeda a “cair” e escolher um estado. Além da superposição, os qubits possuem outra propriedade quase mágica: o emaranhamento. Quando dois qubits estão emaranhados, eles formam um único sistema interligado. O estado de um afeta instantaneamente o do outro, não importa quão distantes estejam. É o que Einstein famosamente chamou de “ação fantasmagórica à distância”.

Combinadas, a superposição e o emaranhamento permitem que um computador quântico explore um número vasto de soluções potenciais de uma só vez, conferindo-lhe seu poder computacional sem paralelo para certos tipos de problemas.

A Maldição da Decoerência

Essa capacidade fantástica, no entanto, é extremamente frágil. O estado quântico de um qubit é como um castelo de cartas delicadíssimo construído no meio de um furacão. A menor perturbação do ambiente externo — uma leve flutuação de temperatura, uma vibração perdida, um campo eletromagnético errante — pode fazer tudo desmoronar instantaneamente. Esse colapso do estado quântico é chamado de decoerência. É o inimigo número um da computação quântica. Proteger os qubits da decoerência é, portanto, a prioridade máxima. Para conseguir isso, os cientistas precisam criar o ambiente mais silencioso, estável e isolado que a tecnologia humana pode produzir, uma verdadeira fortaleza contra o caos do mundo exterior.

A Fortaleza de Gelo

Essa fortaleza assume a forma de um refrigerador de diluição, uma maravilha da engenharia criogênica. Essas máquinas, que parecem lustres dourados e complexos saídos de um filme de ficção científica, são projetadas para atingir temperaturas de alguns milli-Kelvin. Para colocar isso em perspectiva, o zero absoluto, o ponto em que todo movimento atômico cessa, é 0 Kelvin (-273,15 °C). O espaço profundo, longe de qualquer estrela, tem cerca de 3 Kelvin. Um refrigerador de diluição é centenas de vezes mais frio que o espaço sideral. Nesse frio extremo, o “ruído” térmico do universo é quase completamente silenciado, dando aos qubits a tranquilidade de que precisam para manter seus delicados estados quânticos por tempo suficiente para realizar cálculos úteis.

O Gargalo de Um Milhão de Fios

Ao resolver o problema do ruído térmico com a criogenia, a ciência se deparou com um paradoxo prático que se tornou o maior obstáculo para a escalabilidade do computador quântico. Enquanto os qubits (a orquestra) precisam do frio extremo para funcionar, a complexa eletrônica necessária para enviar e receber sinais de cada um deles (o maestro) opera em temperatura ambiente e gera uma quantidade significativa de calor. Por anos, a solução foi manter o maestro em uma sala separada e climatizada, e conectar cada músico da orquestra individualmente por meio de cabos especiais. Essa abordagem, embora funcional para alguns poucos qubits, criou um pesadelo de engenharia que impedia qualquer avanço real para máquinas com milhares ou milhões de qubits.

A Crise da Fiação

Imagine a cena. Para cada qubit dentro da fortaleza de gelo, era preciso passar um cabo coaxial de alta frequência desde os equipamentos em temperatura ambiente até o coração do refrigerador. Um computador com 50 qubits precisava de 50 cabos. Um com mil qubits, mil cabos. Um com um milhão de qubits? Um milhão de cabos. A imagem mental é a de um emaranhado de espaguete metálico, uma teia de fios que não só era fisicamente impraticável de montar e gerenciar, mas que também agia como um aqueduto para o inimigo: o calor. Cada fio, por mais bem isolado que fosse, conduzia uma pequena quantidade de calor do mundo exterior para o santuário gelado, aquecendo o sistema e limitando o número de qubits que poderiam ser resfriados eficazmente. Era um ciclo vicioso: para adicionar mais poder (qubits), era preciso adicionar mais complexidade (fios), que por sua vez minava o próprio ambiente necessário para o poder existir.

Primeiras Tentativas de Solução

A comunidade científica estava plenamente ciente de que o “gargalo da fiação” era uma parede contra a qual o campo inteiro poderia colidir e estagnar. A solução lógica era miniaturizar o maestro e colocá-lo para trabalhar dentro da própria sala de concertos gelada. Grandes players da indústria, como a Intel em colaboração com a QuTech, fizeram progressos notáveis nessa direção. Eles desenvolveram chips de controle criogênico, como o “Horse Ridge”, projetados para operar a temperaturas de alguns Kelvin. Esses foram passos cruciais, provando que era possível fazer eletrônica de silício funcionar em ambientes frios. No entanto, ainda havia uma barreira final: para um controle verdadeiramente eficiente e integrado, o chip de controle precisava operar não a poucos Kelvin, mas a milli-Kelvin, na mesma faixa de temperatura dos qubits e a uma distância de meros micrômetros, algo que muitos consideravam impossível devido à dissipação de calor da própria eletrônica.

A Revolução Cryo-CMOS: A Solução Nascida no Silício

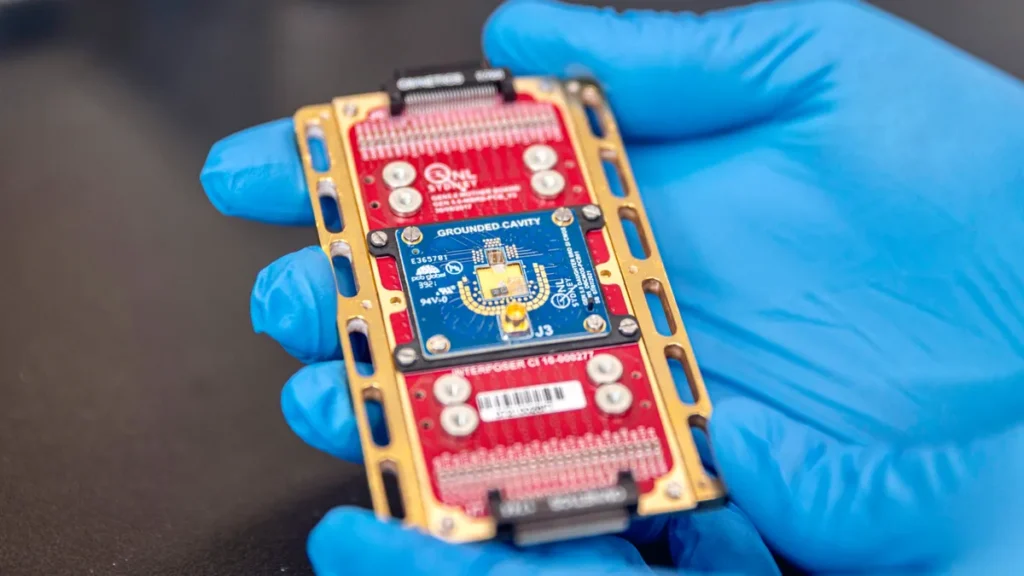

A solução para esse desafio aparentemente intransponível não veio de um material novo e exótico, mas da tecnologia mais onipresente e bem-sucedida da história da humanidade: o silício. Em um trabalho publicado na prestigiada revista Nature, uma equipe da Universidade de Sydney, liderada pelo Professor David Reilly, demonstrou um chip de controle que alcança o que era considerado o santo graal da engenharia quântica. Eles criaram um dispositivo capaz de operar com perfeição a temperaturas de milli-Kelvin e a menos de um milímetro de distância dos qubits, eliminando a necessidade da fiação massiva e resolvendo de uma vez por todas o gargalo de calor e complexidade.

A Equipe e a Visão de Uma Década

Este não foi um golpe de sorte, mas o culminar de mais de uma década de esforço focado. O Professor Reilly e sua equipe identificaram esse problema de controle como um potencial “showstopper” — um obstáculo capaz de parar todo o progresso — muito tempo atrás. Eles apostaram que, sem uma solução para a interconexão, o computador quântico em larga escala jamais sairia do papel. Assim, eles se dedicaram a um objetivo singular e ambicioso: projetar um chip de controle que pudesse viver no mundo gelado dos qubits, uma tarefa que exigia repensar fundamentalmente como os circuitos eletrônicos se comportam nos limites mais frios da física.

O Poder do Onipresente CMOS

A genialidade da abordagem da equipe de Sydney foi usar a tecnologia CMOS (Complementary Metal-Oxide-Semiconductor). Este é o processo de fabricação padrão usado para criar os bilhões de transistores em praticamente todos os dispositivos eletrônicos que usamos, de smartphones a supercomputadores. Ao adaptar uma tecnologia já madura, barata e massivamente escalável, eles garantiram que sua solução não seria apenas uma curiosidade de laboratório, mas um caminho viável para a produção industrial. Eles não inventaram um novo tipo de material; eles ensinaram um truque novo e extraordinariamente difícil para o cavalo de batalha da indústria eletrônica.

Domando a Física no Zero Absoluto

Fazer um chip CMOS funcionar em temperaturas próximas do zero absoluto é uma proeza. Nesse frio extremo, o comportamento dos elétrons nos semicondutores muda drasticamente, e a dissipação de calor, por menor que seja, torna-se uma ameaça catastrófica. Um processador de laptop consome dezenas de watts de energia, exigindo ventoinhas para resfriamento. O chip desenvolvido pela equipe de Reilly, no entanto, é uma obra-prima de eficiência energética. Durante a operação, ele dissipa meros 10 microwatts — um milionésimo da potência de uma lâmpada de LED. Essa geração de calor quase nula é a chave que permite que ele seja colocado como um vizinho imediato dos qubits sem perturbá-los com sua atividade, resolvendo o problema térmico que as soluções anteriores não conseguiam superar.

A Prova Definitiva

Para provar a eficácia de seu sistema, a equipe integrou seu chip cryo-CMOS com qubits de spin de silício (fornecidos pela Diraq, uma empresa spin-out da UNSW Sydney). O chip foi posicionado a menos de um milímetro dos qubits e usado para gerar os pulsos de micro-ondas precisos necessários para controlar seus estados quânticos, executando operações de um e dois qubits. Os resultados foram inequívocos e impressionantes. O controle foi exercido com altíssima fidelidade, comparável aos melhores sistemas de controle em temperatura ambiente. Mais importante, não houve nenhuma evidência de que o chip introduziu ruído adicional ou reduziu o tempo de coerência dos qubits. A prova estava completa: o maestro podia, de fato, reger a orquestra de dentro da fortaleza de gelo, silenciosa e eficientemente.

Um Novo Horizonte de Aplicações

A resolução do gargalo de controle e escalabilidade não é apenas uma vitória acadêmica; é o evento que dispara a largada para uma nova era de aplicações práticas da computação quântica. A capacidade de projetar um processador com milhões de qubits em um único chip transforma a máquina de uma ferramenta de pesquisa especializada em um recurso computacional capaz de enfrentar problemas que hoje estão completamente fora do alcance da humanidade. O impacto dessa transição será sentido em praticamente todos os campos do conhecimento e da indústria, desde a medicina e a sustentabilidade até as finanças e a inteligência artificial.

A Simulação Perfeita da Natureza

Muitos dos maiores desafios científicos, especialmente na química e na biologia, são fundamentalmente problemas quânticos. Simular com precisão como uma molécula de proteína se dobra (um problema central para doenças como Alzheimer e Parkinson) ou como um novo catalisador irá interagir com outros compostos é computacionalmente impossível para computadores clássicos. Um computador quântico em larga escala, no entanto, pode simular a natureza em seus próprios termos. Isso permitirá o design de novos medicamentos com uma velocidade e precisão sem precedentes, a criação de enzimas para quebrar plásticos de forma eficiente, o desenvolvimento de fertilizantes que não agridam o meio ambiente e a invenção de novos materiais com propriedades sob medida, como supercondutores em temperatura ambiente.

Otimização em Escala Planetária

Outra classe de problemas em que os computadores quânticos se destacam é a otimização. Imagine tentar encontrar a rota mais eficiente para uma frota de milhares de veículos de entrega em uma cidade, levando em conta o trânsito, o consumo de combustível e as janelas de entrega. O número de combinações possíveis explode rapidamente, tornando o problema insolúvel para a computação clássica. Com o poder do processamento paralelo quântico, poderíamos resolver esses quebra-cabeças logísticos em tempo real, otimizando cadeias de suprimentos globais, projetando redes de energia mais eficientes e criando modelos financeiros que gerenciam riscos de forma muito mais inteligente e robusta.

A Ameaça e a Promessa da Criptografia

Talvez a aplicação mais famosa (e infame) de um computador quântico em larga escala seja sua capacidade de quebrar a maioria dos sistemas de criptografia que protegem nossas comunicações e dados hoje. O algoritmo de Shor, um algoritmo quântico, pode fatorar grandes números de forma eficiente, uma tarefa que é a base da segurança de sistemas como o RSA. A chegada de um computador quântico tolerante a falhas tornaria grande parte de nossa infraestrutura digital vulnerável. No entanto, essa ameaça impulsionou simultaneamente o desenvolvimento de soluções, como a Criptografia Pós-Quântica (PQC), que são algoritmos clássicos projetados para serem seguros contra ataques quânticos. A era quântica, portanto, forçará uma atualização completa em nossa forma de pensar sobre segurança digital.

Os Próximos Desafios no Caminho Quântico

Com a solução para o controle em mãos, a estrada para o computador quântico funcional está mais clara do que nunca, mas isso não significa que não haja mais obstáculos. Na verdade, a resolução de um grande problema muitas vezes serve para iluminar com mais clareza os próximos desafios que precisam ser superados. A corrida agora se desloca de uma questão de interconexão para questões de fabricação, qualidade e programação em uma escala nunca antes vista.

A Fábrica de Qubits

Ter um sistema de controle para um milhão de qubits é inútil se não pudermos fabricar um milhão de qubits que sejam de alta qualidade e quase idênticos entre si. Pequenas imperfeições no processo de fabricação do silício podem levar a variações no comportamento de cada qubit, tornando o sistema como um todo não confiável. Desenvolver processos de fabricação em massa com o nível de precisão atômica necessário para produzir processadores quânticos em larga escala é agora um dos maiores focos da engenharia na área.

O Software para a Máquina do Futuro

Um hardware revolucionário exige um software igualmente revolucionário. Um computador quântico não executa os mesmos programas que um computador clássico. Ele requer algoritmos quânticos projetados especificamente para explorar os princípios da superposição e do emaranhamento. Embora alguns algoritmos fundamentais como o de Shor e o de Grover já existam, o campo de desenvolvimento de software quântico ainda está em sua infância. Construir as ferramentas, linguagens de programação e algoritmos que permitirão aos desenvolvedores aproveitar todo o poder dessas novas máquinas é um campo de pesquisa paralelo e igualmente vital.

Correção de Erros: A Batalha Constante

Finalmente, mesmo com o melhor isolamento e controle, os qubits sempre estarão suscetíveis a erros. A solução para isso é a correção de erros quânticos. A ideia é usar a redundância: agrupar muitos qubits físicos frágeis para criar um único “qubit lógico” que seja muito mais robusto e tolerante a falhas. As estimativas variam, mas pode ser necessário de mil a dez mil qubits físicos para criar um único qubit lógico de alta fidelidade. Portanto, a capacidade de fabricar e controlar milhões de qubits, habilitada por este avanço, é o pré-requisito absoluto para construir um computador quântico verdadeiramente útil e tolerante a falhas.

Conclusão: A Aurora de uma Nova Era

O caminho para a computação quântica sempre foi visto como uma maratona cheia de muros altos. O gargalo da fiação e do controle era, talvez, o muro mais alto e intimidante de todos. Não era uma barreira imposta pelas leis fundamentais da física, mas sim um desafio monumental de engenharia. O que a equipe da Universidade de Sydney e seus colaboradores demonstraram é que esse muro pode ser escalado. Sua solução, elegante em seu uso de tecnologia padrão e brilhante em sua execução, não nos entrega um computador quântico de mesa amanhã. Em vez disso, ela nos oferece algo muito mais valioso: um roteiro claro e viável. Ela transforma a pergunta de “se” algum dia teremos computadores quânticos em larga escala para “como e quando” os construiremos. Estamos testemunhando a transição da pesquisa fundamental para a engenharia aplicada. A aurora da era quântica não é mais um ponto distante no horizonte; seus primeiros raios estão começando a iluminar o nosso presente.

O que você acha que um computador quântico com milhões de qubits poderia resolver primeiro? Qual aplicação teria o maior impacto na sua vida? Deixe sua opinião nos comentários e assine nossa newsletter para não perder os próximos capítulos desta revolução científica!

Fontes

QuTech: Cold chips can control qubits — [2021]

Live Science: ‘This result has been more than a decade in the making’ — [2025]

The University of Sydney: Control of spin qubits at near absolute zero a game changer for quantum computers — [2025]

Nature: A cryogenic CMOS chip for generating control signals for multiple qubits — [2025]